利用边界校正网络提取建筑物轮廓

胡敏,况润元,陈增辉,刘静

(江西理工大学,江西 赣州 341000)

摘要:基于影像自动提取建筑物轮廓是遥感领域在现代化城市建设中长期存在的问题。为了充分利用高分辨率遥感影像中建筑物的全局和局部信息以更精确地对建筑物进行分割和提取,提出了基于全卷积神经网络的针对边界约束的校正神经网络模型。该模型由共享后端和多任务预测模型组成,利用修改的U-net和多任务框架,根据共享后端的一致特征生成分割图预测和轮廓构建。模型通过对边界信息的限制和规定,提高性能。在建筑物数据库上的实验表明,边界校正网络模型在建筑物分割和轮廓提取的结果精度均在89%以上,优于传统的U-net模型结果。

关键词:全卷积神经网络;建筑物提取;图像分割;轮廓提取;U-net模型

0 引言

建筑物屋顶轮廓的自动提取是遥感在土地类型利用分析以及地图自动更新和生成等应用领域中一个长期存在的问题[1]。近年来,基于成像传感器和其操作平台的快速发展,高分辨率遥感图像的可利用性快速发展使得该问题日益突出[2]。由于颜色、亮度和纹理条件的复杂性,使得从包含各类地物影像中提取建筑物屋顶更为复杂,因此适合采用先构建建筑物屋顶,再由分割生成屋顶轮廓[3]。在数据源上有基于图像数据[4]、点云数据[5]和图像点云组合数据[6]3类。分割算法上可分为阈值分割法[7-8]、图像分割法[9-11]、神经网络分割法[12]。其中,基于神经网络算法根据地面真实数据进行模式学习,再将结果模型应用于新图像,可以根据地表真实数据进行调整[13]。但其仅通过人工描绘[14]从图像中提取特征,利用各种分类器进行分类[15],需进行大量反复实验,耗费劳力且缺乏泛化能力。而卷积神经网络[16]通过利用卷积,子采样和全连接自动提取特征并执行分类[17],且特征提取直接基于数据中学习,具有更高的泛化能力和精度[18]。

LSVRC-2010大赛中采用了卷积神经网络算法的AlexNet以压倒性优势获胜,且对数据进行开源的优势[19],使得基于卷积神经网络算法已成为众多计算机视觉任务(如图像分类、物体检测和图像分割等)中的基础算法[20]。但由于其极高的内存成本和低计算效率,使得全卷积网络引起了更多的关注[20]。FCN对图像采用像素级的分类,接受任意尺寸的输入图像,并采用反卷积层对最后一个卷积层的feature map进行上采样, 使其恢复与输入图像同尺寸,保留原始空间信息,上采样时进行逐像素分类[21],降低了内存成本和参数数量,提升处理效率[22]。但在上采样过程中依然会引起部分边缘信息丢失,使得FCN的预测结果通常具有边缘模糊和一定的精度限制。

为克服全卷积网络模型的局限性,语义分割网络[23]将传统的上采样操作替换为非采样。反卷积网络[24]引入新的反卷积层产生上采样结果,解决部分由上采样操作引起的信息丢失。U-net[25]和特征金字塔网络[26],采用跳跃式连接以产生输出;多约束全卷积网络[27]利用多约束防止偏差。但此类算法仅专注于以信息保留替换双线性上采样(如语义分割网络和反卷积网络),或通过添加跳跃层利用隐藏层特征(如U-net和多约束全卷积网络),其在生成预测区域值时仅采用了局部特征,忽略了形状信息和线性关系等全局信息,使得建筑物多边形各点间和多边形各直线间的信息被忽略。在数据获取过程亦存在建筑物被周围植被遮挡和建筑物间相互遮挡等情况,此时使得模型对于边界识别的预测值与真实值之间的差距越来越大。

针对此类问题,本文提出了一种利用局部和全局边界信息,以实现更好的屋顶分割和更准确的轮廓提取的深度卷积神经网络模型,称为边界校正网络(boundary regulated network,BR-net)模型。并在武汉大学的开源数据库(WHU)[28]中的航空影像和卫星影像数据集上进行实验,证明了所提出的BR-net模型的有效性。

1 实验方法

1.1 研究方法

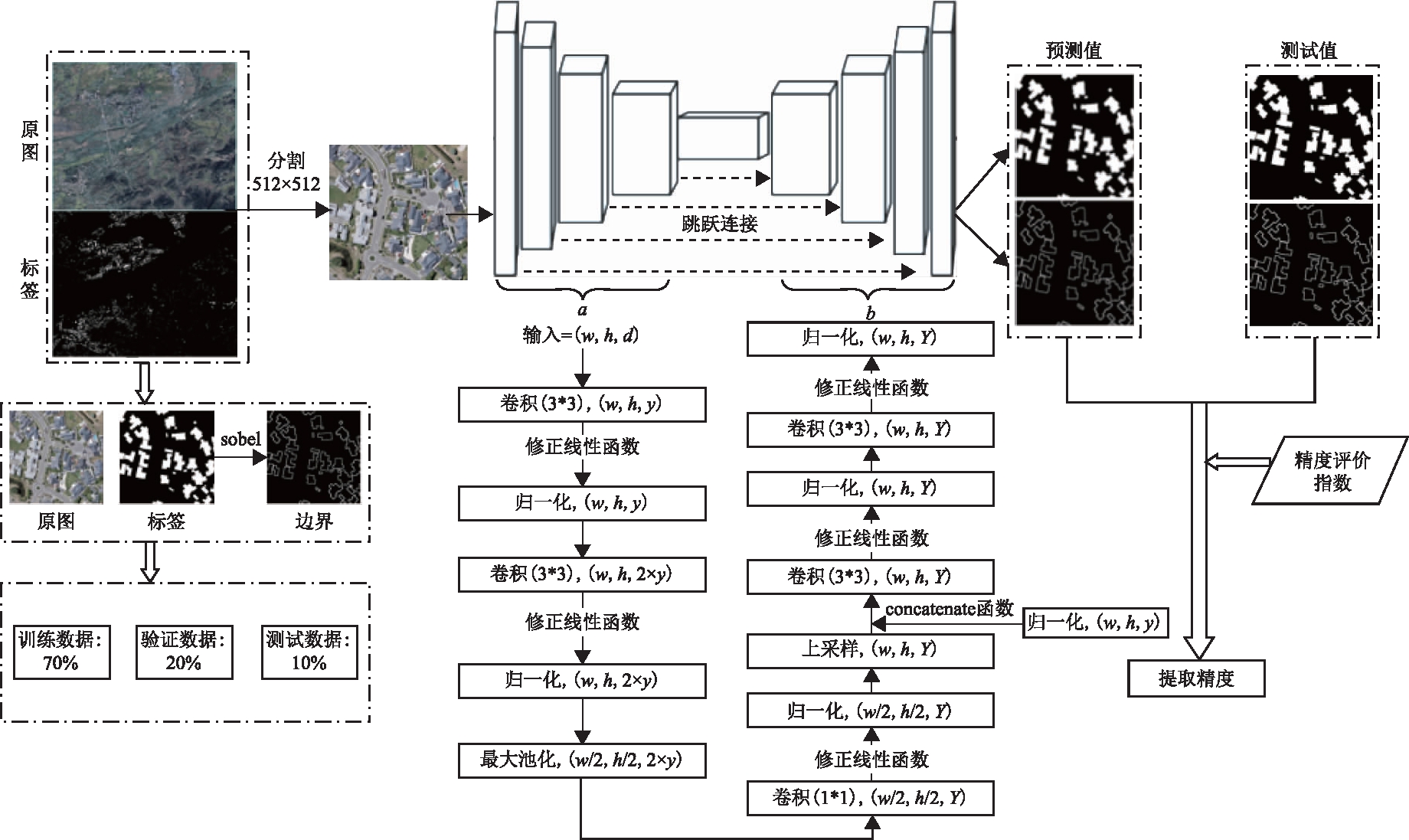

经典的FCN模型采用全卷积层执行输入到输出间的像素到像素的转换,并通过删除全连接层,以减少模型的参数量,提高模型性能。基于全卷积网络的改进模型通过利用非抽样(语义分割网络)、反卷积(反卷积网络)、跳跃链接(U-net)和多约束(多约束全卷积网络)等方式来提高模型性能,但其每个像素的预测值也是仅基于局部信息(如3×3或5×5)内的特征进行结果预测的,依旧无法利用建筑的边界全局信息。同时在图像获取时,会产生大量噪声数据(建筑物间遮挡,植被遮挡等)误差。若网络模型仅通过周围像素之间的差异进行图像分割,则导致建筑物的边界等信息被浪费。为克服此类局限,本文所提出的BR-net模型采用多任务学习进行分割和轮廓提取,以充分利用图像的局部和全局信息。在训练阶段,优化器用以确保分割和轮廓提取预测结果与相应的建筑物标签数据保持一致。在每次迭代期间,建筑物的边界信息可以限制和调节参数更新,将防止映射模式偏向周围像素的分割。模型由2个部分组成:优化的U-net型全卷积神经网络为共享后端、生成分割和轮廓提取的双预测框架(图1)。共享后端由4个下采样层、一个中央转换层和4个上采样层组成。中央层为一个内核数为384的3×3的卷积层,后接LeakyReLU激活函数和BN层,在下采样层间的第二BN层和上采样层间的相应上采样层之间采用跳跃连接。卷积运算是通过内核执行的逐元素乘法,内核的大小决定了接收领域的范围。与整数线性单位(ReLU)相比,它将所有小于0的值设置为0,输出由Leaky ReLU[29]激活函数处理,其中,α的值设置为0.1。采用最大值池化对中间层特征的高度和宽度进行二次采样;同时选取双线性上采样和跳跃连接,使输入和输出的图像大小保持一致;最后选择sigmoid激活函数生成分割预测结果。通过网络训练和交叉验证,以优化并确定超参数学习率和迭代次数,再根据由优化的超参数训练得到的网络模型对测试集进行测试,最终生成测试集的建筑物结果。模型的初始输入参数为512像素×512像素的RGB图像。

1)下采样层中,h、w和d分别代表输入的高度、宽度和深度;y表示用于卷积的内核数。含2个卷积层、2个LeakyReLU激活函数、2个BN层和一个最大池化层。对于每个输入,下行层会生成宽度和高度减半的输出。4个层中的内核数分别为[24、48、96、192]。

2)上采样层中,h、w和d分别代表输入的高度、宽度和深度;Y和y分别表示下行层中相应BN层的尺寸和用于卷积运算的内核数。含一个双线性上采样层、一个跳跃连接层和3个卷积层,后接LeakyReLU激活函数和BN层。上行层将输入的宽度和高度加倍。4个层中的内核数分别为[192、96、48、24]。

图1 技术路线

共享后端的输出是具有与输入图像一致宽度和高度的3D矩阵。将单个1×1卷积核跟sigmoid激活函数应用于输出分割结果图的预测。类似采用具有S形激活函数的单个3×3卷积核用于生成建筑物轮廓。然后选取预测值和相应的地面真值之间的二元交叉熵[29]对分割损失和轮廓损失进行计算。计算每项损失的表达如式(1)所示。

(1-gi,j)×ln(1-yi,j)

(1)

式中:h和w表示预测结果的高度和宽度(y)及相应的地表真实值(g);yi,j的值为像素类别预测结果的概率值。BR-net的总损失结果的表达如式(2)所示。

lossfinal=(1-α)×lossseg+α×lossbou

(2)

式中:α为边界损失的权重(lossbou)。本次实验中,α的值设为0.5。在每次迭代中,当Adam优化器将最终损失最小化时,BR-net模型学习得到对应的映射模式,其可根据单个输入产生分割和轮廓的预测。

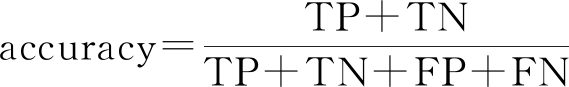

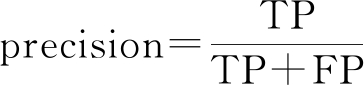

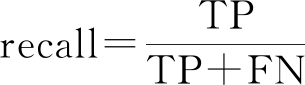

1.2 评价指标

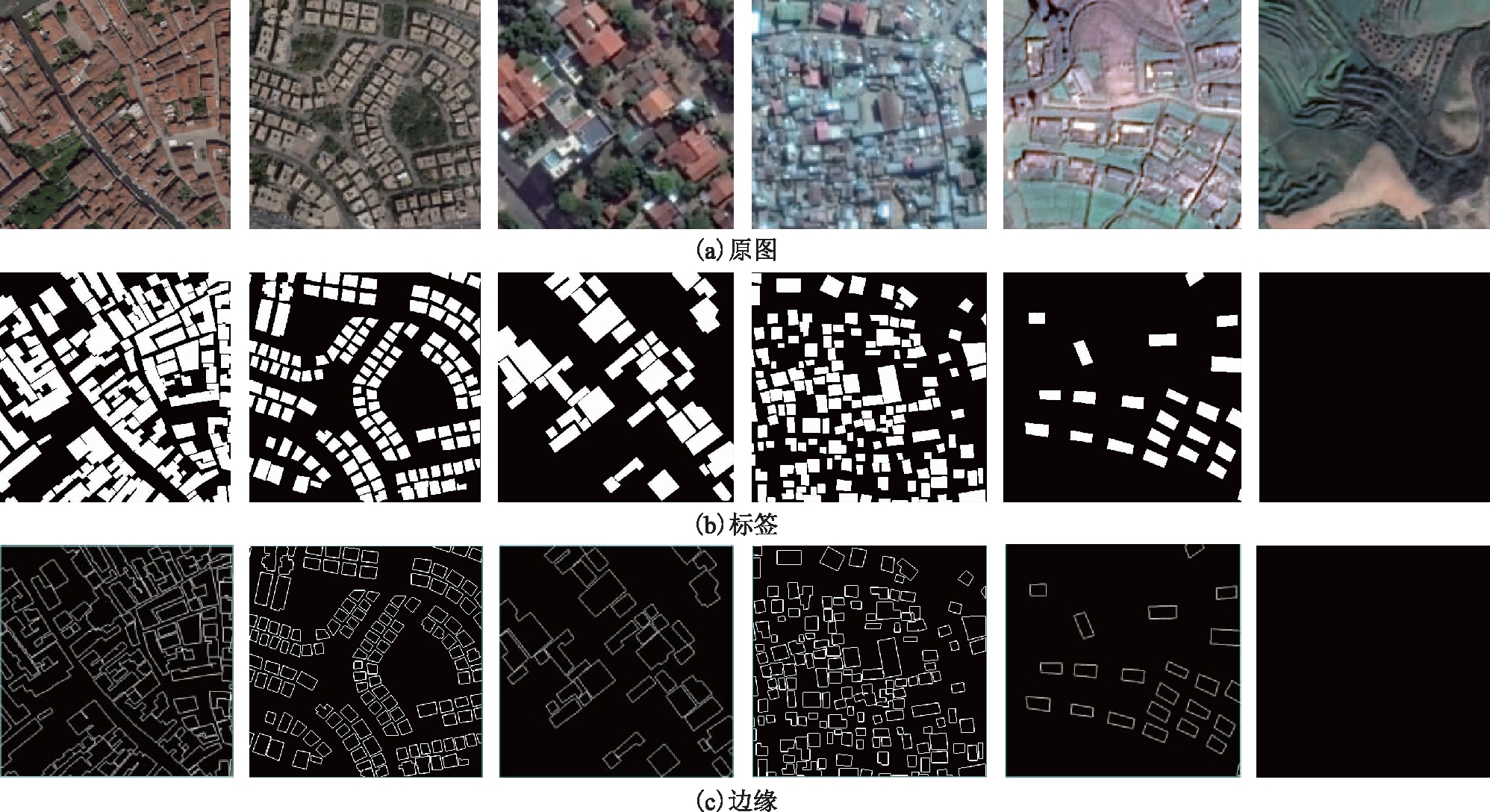

为了充分反映边界校正全卷积网络对于样本的分割性能,选取提取结果的准确率(accuracy)、精确率(precision)、召回率(recall)、F1、Kappa系数以及平均交并比(mean intersection-over-union, mIoU)6类指标来衡量提取结果的精度。mIoU即目标区域和预测区域之间的重合度,也就是用来表示某类标签(ground truth,GT)的像素集合和预测(prediction,P)结果像素集合之间的交集比上并集。

6类指标的表达如式(3)~式(8)所示。

(3)

(4)

(5)

(6)

(7)

(8)

式中:TP为正确分类的像元数量;FN为漏分类的像元数量;FP为过分类的像元数量;TN为误分类的像元数量;P0为总体分类精度;Pe为真实像元与分类像元的积之和除以总像元数目的平方。计算IoU时,进一步转换如式(9)所示。

(9)

IoU的取值范围在0到1之间,值越大说明预测效果越好,当GT和P完全重合的时候为最大值1。平均交并比mIoU如式(10)所示。

(10)

式中:m表示数据标签类别个数;iIoU表示第i个类别的交并比。

同时,为了最直观地反映改进后该网络模型的性能,所有指标均采用未经任何数学形态学后处理[30]的情况下进行计算。

2 实验结果与分析

2.1 数据源

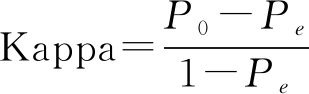

本文使用的数据来自WHU数据库,该数据库分成航空建筑物数据库和卫星建筑物数据库。航空影像数据来自新西兰克赖斯特彻奇市(Christchurch),涵盖22万栋形式各异的建筑,地面分辨率0.075 m,后期将数据下采样到0.3 m。卫星影像数据包含来自不同卫星传感器(ZY-3、Ikonos、WorldView系列等)、不同分辨率(0.3~2.3 m),包括亚洲、欧洲、北美洲、南美洲和非洲5大洲的不同城市,共含3.4万栋建筑物。图2和图3分别展示了航空影像数据集和卫星影像数据集的部分样例,其中原图和标签数据均采用WHU数据集。同时,根据数据集中的标签集,采用Python编程进行Sobel滤波,得到所有建筑物顶的外部轮廓即边界数据,以充分利用建筑物顶多边形的全局信息,即点间的方位关系与线间的角度关系。

图2 航拍影像数据集示例

图3 卫星影像数据集示例

所有数据的大小均调整为512像素×512像素。本文主要将数据分成航空影像数据集、卫星影像数据集,进行网络模型训练。各类数据集中均采用70%数据作为训练集,20%的数据作为验证集,10%的数据作为测试集。表1为WHU数据库与其他国际开源数据库的对比。

表1 WHU数据库与其他国际开源数据库的总体比较[28]

2.2 验证分析

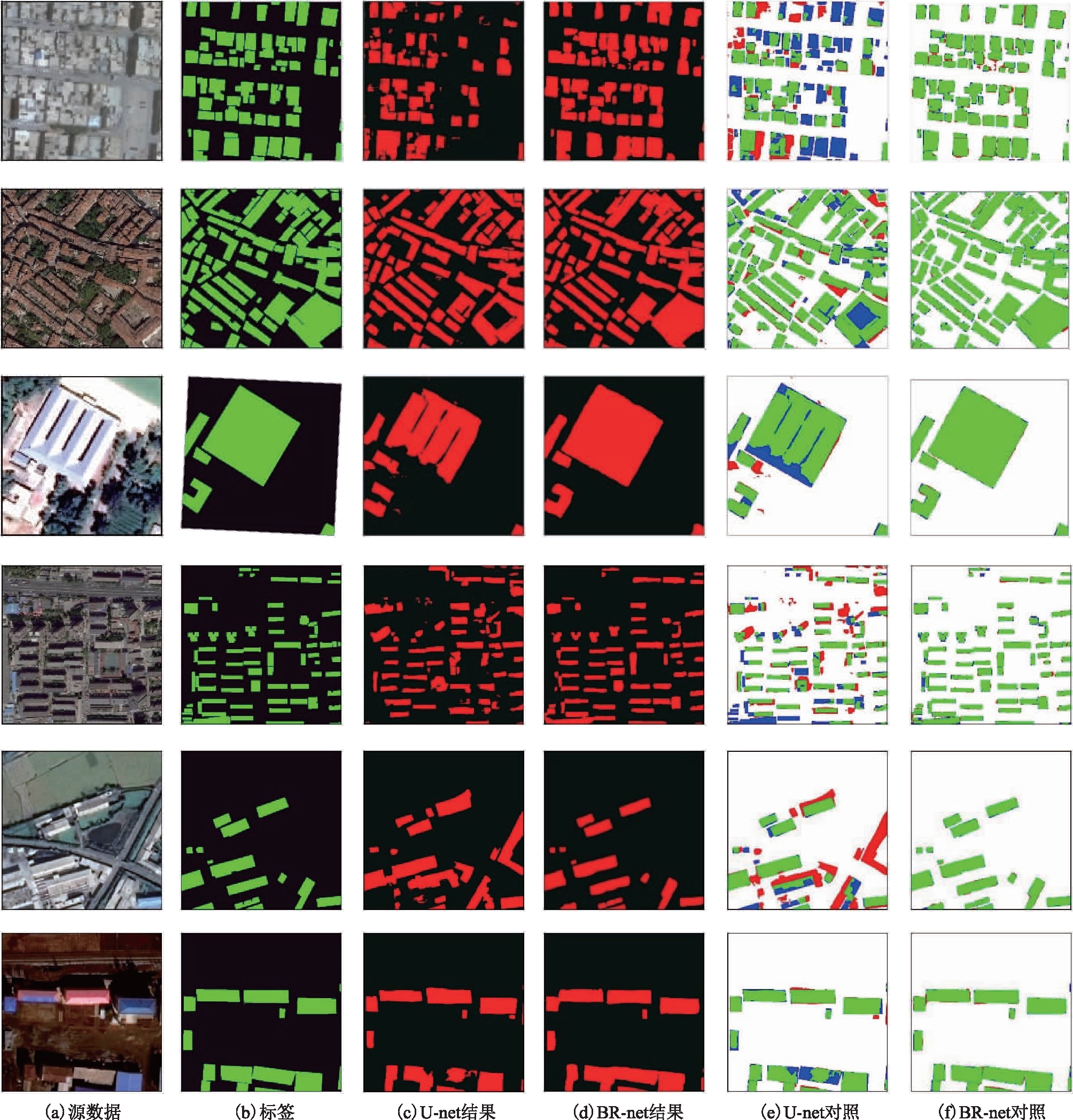

本文采用经典的U-net模型为基础模型与BR-net模型结果进行横向比较,使用相同的数据集与处理平台进行建筑物顶提取。从建筑物顶轮廓提取结果的定性判别中对照图4(其中,绿色对应代表区为true positive(TP);蓝色对应代表区为false negative(FN);红色对应代表区为false positive(FP);白色对应代表区为true negative(TN))。可见,无论是在航空影像数据集还是在卫星影像数据集基础上的轮廓提取结果,BR-net模型均明显优于传统U-net模型的提取结果。从建筑物的屋顶轮廓上看,改进后的BR-net模型所提取的建筑物顶轮廓,与基准屋顶的轮廓吻合度明显更优(图5),特别是在建筑物顶的直角拐角处,采用传统U-net模型的提取结果大部分出现了过度分类的情况,主要因为在网络中没有加入边界校正全卷积网络的误差限制条件;同时,在负样本(没有建筑物但存在其他地类图像)中,U-net模型将具有高亮反射区域的部分道路提取为建筑物,存在明显误差,总体表现在:较为大型的建筑物上,U-net模型的提取结果区域对于地表真实区域过大;在较小型密集建筑物区域,U-net模型提取的建筑物区域对于地表真实区域过小。

图4 航空影像建筑物顶提取结果对比

图5 卫星影像建筑物顶提取结果

定量提取的建筑物顶结果(表2)显示了航空影像和卫星影像测试区域在U-net模型和BR-net模型间的6类提取精度比较。在总体精度上,BR-net模型的精度结果均明显优于U-net模型。其中,2类模型在卫星影像和航空影像2类影像的精度差异上,卫星影像数据集上的精度差异较低。在准确率、精确率、召回率、F1、Kappa系数以及平均交并比上,BR-net的总体精度分别提升了8.95%、16.01%、25.23%、23.42%、26.89%和33.57%,且在6类精度中BR-net模型的建筑物提取精度均达到89%以上。

表2 建筑物顶提取结果精度对比

3 结束语

本文提出了一种新的边界校正全卷积网络模型,用于精确进行屋顶分割预测,并基于WHU影像数据集进行建筑物轮廓提取。所提出的BR-net模型能够基于RGB图像进行建筑物的自动分割预测和轮廓提取。采用WHU数据集上的航空影像数据和卫星影像数据,分别对改进后的网络进行了6类精度评估。BR-net模型凭借其独特的边界限制条件和误差调节设计,比经典的U-net模型得到了更高的精度提取结果。与U-net模型相比,在对航空影像和卫星影像建筑物顶提取精度中的mIoU精度及Kappa系数分别提高了(0.478、0.193)和(0.362、0.174)。在今后研究中,将进一步探寻更优化的网络架构,力求以更低的计算成本实现更好的网络模型计算性能。

参考文献

[1] 惠健,秦其明,许伟,等.基于多任务学习的高分辨率遥感影像建筑实例分割[J].北京大学学报(自然科学版),2019,55(6):1067-1077.

[2] DU P,LIU Y,CHENG L, et al.A review of supervised object-based land-cover image classification[J].ISPRS Journal of Photogrammetry and Remote Sensing,2017,130:277-293.

[3] LI M. A review of remote sensing image classification techniques:the role of spatiocon textual information[J]. European Journal of Remote Sensing, 2014, 47:389-411.

[4] CHEN R,LI J. Object-based features for house detection from RGB high-resolution images[J].Remote Sensing,2018,11(3):451.

[5] XU B,JIANG W,SHAN J, et al. Investigation on the weighted RANSAC approaches for building roof plane segmentation from LiDAR point clouds[J].Remote Sensing,2015,8(1):5.

[6] HUANG Y, ZHOU L, TAO H, et al. A novel building type classification scheme based on integrated LiDAR and high-resolution images[J]. Remote Sensing, 2017, 10(7):679.

[7] KANOPOULOS N, VASANTHAVADA N, BAKER R L. Design of an image edge detection filter using the Sobel operator[J]. IEEE Journal of Solid-state Circuits, 1988, 23(2):358-367.

[8] 赵宗泽,张永军.基于植被指数限制分水岭算法的机载激光点云建筑物提取[J].光学学报, 2016, 36(10):493-501.

[9] XIE S, TU Z. Holistically-nested edge detection[J].International Journal of Computer Vision,2017,125(1/3):3-18.

[10] 李云松,李明.基于灰度空间特征的模糊C均值聚类图像分割[J].计算机工程与设计, 2007, 28(6):1358-1360.

[11] 任小康,邓琳凯.基于颜色聚类分割及改进的FMM算法的壁画修复[J].计算机工程与科, 2014, 36(2):298-302.

[12] 黄小赛,李艳,马佩坤, 等.基于卷积神经网络的建筑物精细化提取[J].地理空间信息,2018,16(3):97-100.

[13] ZHOU J, CHAN K L, CHONG V F. Extraction of brain tumor from MR images using one-class support vector machine[C]//International Conference of the Engineering in Medicine & Biology Society.[S.l.]:IEEE, 2006:6411-6414.

[14] 慎利,方灿明,王继成, 等.场景解译框架下的高铁沿线建筑物自动识别[J].遥感信息,2018,33(3):77-84.

[15] IEEE. Proceedings of the Seventh IEEE International Conference on Computer Vision[C].[S.l.]:IEEE, 2002.

[16] AYTEKIN Ö, ZONGUR U, HALICI U. Texture-based airport runway detection[J]. IEEE Geoscience and Remote Sensing Letters, 2013, 10(3):471-475.

[17] LECUN Y, BENGIO Y. Convolutional networks for images, speech, and time series[M]//The Handbook of Brain Theory and NEURAL NETWORKs. Cambridge:MIT Press, 1998.

[18] CIREAN D C, GIUSTI A, GAMBARDELLA L M. Deep neural networks segment neuronal membranes in electron microscopy images[J]. Advances in Neural Information Processing Systems, 2012, 25:2852-2860.

[19] EVERINGHAM M, GOOL L V, WILLIAMS C K I, et al. The pascal visual object classes (VOC) challenge[J]. International Journal of Computer Vision, 2010, 88(2):303-338.

[20] 董蕴雅,张倩.基于CNN的高分遥感影像深度语义特征提取研究综述[J].遥感技术与应用, 2019, 34(1):1-11.

[21] GUO Z, SHAO X, XU Y, et al. Identification of village building via google earth images and supervised machine learning methods[J]. Remote Sensing, 2016, 9(4):271.

[22] 徐逸之,姚晓婧,李祥, 等.基于全卷积网络的高分辨遥感影像目标检测[J].测绘通报,2018(1):77-82.

[23] KAMPFFMEYER M, SALBERG A B, JENSSEN R. Semantic segmentation of small objects and modeling of uncertainty in urban remote sensing images using deep convolutional neural networks[C]//Conference on Computer Vision and Pattern Recognition Workshops (CVPRW).[S.l.]:IEEE Computer Society, 2016:680-688.

[24] NOH H, HONG S, HAN B. Learning deconvolution network for semantic segmentation[C]//IEEE International Conference on Computer Vision (ICCV).[S.l.]:IEEE, 2015:1520-1528.

[25] RONNEBERGER O, FISCHER P, BROX T. U-net:convolutional networks for biomedical image segmentation[C]//International Conference on Medical Image Computing and Computer-Assisted Intervention.[S.l.]:Springer, 2015:234-241.

[26] LIN T,DOLLAR P,GIRSHICK R B,et al.Feature pyramid networks for object detection[C]//IEEE Conference on Computer Vision and Pattern Recognition.[S.l.]:IEEE, 2017:936-944.

[27] WU G,SHAO X,GUO Z,et al.Automatic building segmentation of aerial imagery using multi-cons traint fully convolutional networks[J] Remote Sensing, 2018, 11(3):407.

[28] 季顺平,魏世清.遥感影像建筑物提取的卷积神经元网络与开源数据集方法[J].测绘学报, 2019, 48(4):448-459.

[29] SHORE J, JOHNSON R. Properties of cross-entropy minimization[J]. IEEE Transactions on Information Theory,2003, 27(4):472-482.